ANALÝZA: Rozdám 50 milionů korun, slibuje ve falešném videu Procházka. Jak poznat podvod?

ANALÝZA: Rozdám 50 milionů korun, slibuje ve falešném videu Procházka. Jak poznat podvod?

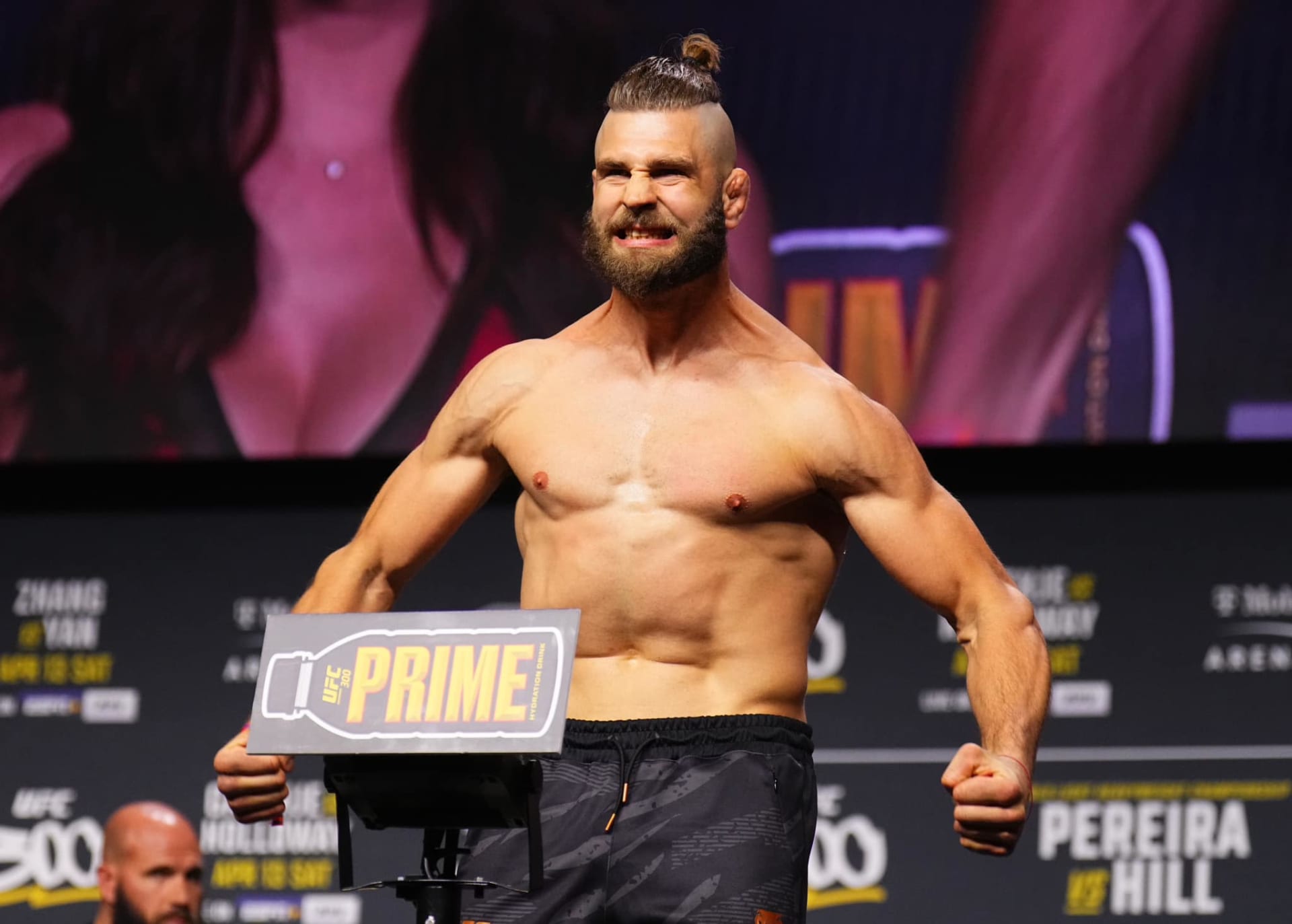

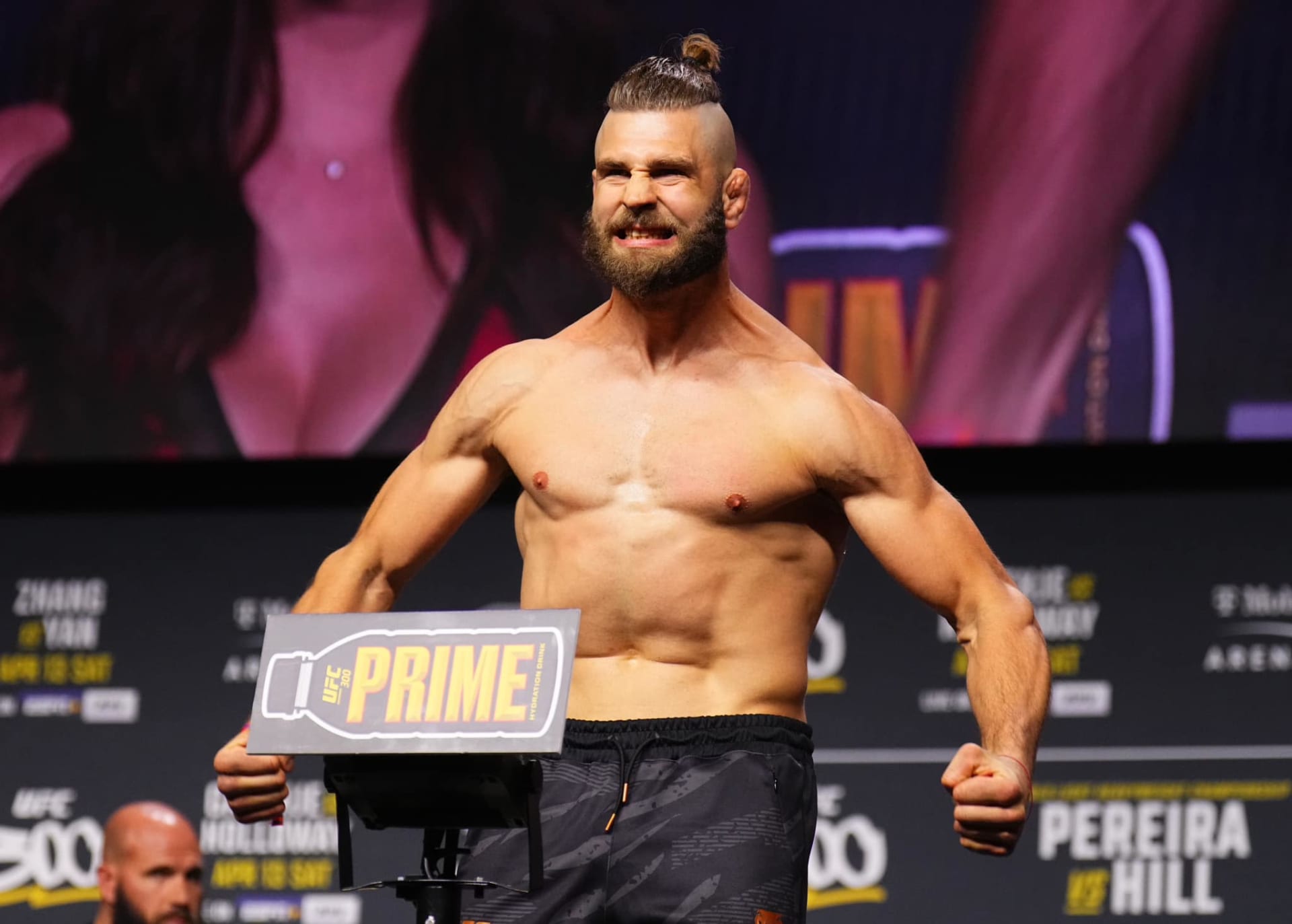

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Profimedia.cz

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: ČTK / Profimedia.cz

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Getty Images

Rozdávám 50 milionů korun, láká údajně MMA bijec Jiří Procházka v rozhovoru pro CNN Prima NEWS. Ve skutečnosti ovšem jde o falešné video, které má z příliš důvěřivých lidí vylákat peníze. Podvodníci použili nástroje umělé inteligence, aby téměř perfektně replikovali hlas zúčastněných. Jak se vyvarovat podobných podvodů? Klíčové faktory popsal redakci CNN Prima NEWS Tomáš Hubínek, expert na AI a ředitel technologické společnosti BigHub.

Ve falešném videu sliboval hlas českého samuraje, že „rozdá mezi svými fanoušky 50 milionů korun přes svou mobilní aplikaci“ jako gesto po svém vítězství v UFC. Upravený rozhovor z Vídně doprovázely doplňující záběry českých bankovek i ukázka sázkové hry Perfect Game, která ve skutečnosti obere nepozorné lidi o peníze. Jak reportér Ondřej Němec, tak Jiří Procházka zní velice autenticky.

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: se souhlasem Jiřího Procházky

UFC bojovník Jiří Procházka Zdroj: repro CNN Prima NEWS

UFC bojovník Jiří Procházka Zdroj: ČTK / Profimedia.cz

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

UFC bojovník Jiří Procházka Zdroj: Se svolením Vieta Trana

„Jde o příklad deepfake s klonovaným hlasem. Samotná obrazová stopa je původní. Pomocí umělé inteligence ale lze dnes samozřejmě generovat celou obrazovou stopu nebo upravovat obraz reálných videí. Typicky třeba face swapem, tedy výměnou obličeje mluvčího za jiného,“ řekl redakci CNN Prima NEWS Tomáš Hubínek, který pomáhá firmám využívat umělou inteligenci.

Falešný rozhovor s „investorem“ Jiřím Procházkou je ale podle něj vydařenou ukázkou, jak kvalitní videa lze v dnešní době vyrobit s umělou inteligencí. Navíc levně, v obrovském množství a bez potřeby hlubších znalostí počítačové grafiky či AI. Mnohdy stačí jen několik návodů na YouTube, aby se člověk rychle zorientoval v dostupných nástrojích.

Pozor na mimiku, rty i intonaci

A podle čeho můžete poznat, že máte před sebou podvodné video? „Jde o hledání odchylek zejména v mimice a gestech, nesoulad zvuku s pohybem rtů, plynulosti pohybů, intonaci či robotičnost hlasu. Dobré je se také podívat, jestli video existuje i někde jinde než na mém zdroji a v jaké kvalitě,“ analyzoval odborník na umělou inteligenci hlavní indicie.

Čtěte také

Čtěte také

Revoluční umělá inteligence. Nový chatGPT už chápe i lidské emoce, bude v telefonech Applu?

Kvůli rychlým pokrokům ve vývoji umělé inteligence se ovšem dá předpokládat, že postupem času bude čím dál obtížnější odhalit upravené video. Brzy by mohly být k nerozeznání od těch skutečných. „Technologicky vidíme snahy obohatit obrázky a videa o znaky – jakýsi otisk prstů – které povedou ke snadnější identifikaci a omezení jejich zneužití,“ nabídl možné řešení Hubínek.

Podvodníkům ale mnohdy stačí opravdu jen málo, aby vyrobili věrně vypadající video. Stačí jim pár vteřin volně dostupných záběrů. Nejdůležitější bývá zpravidla naklonovat a vytvořit syntetický hlas osoby, která ve videu vystupuje. Posléze jí stačí „vložit do úst“ libovolný text.

„Využívání veřejně známých osobností je u těchto videí skoro pravidlem. K vytvoření syntetického hlasu slouží mnoho nástrojů, jedním z nejznámějších je Eleven Labs. Pro generování samotných videí existuje například Synthesia, ale těch nástrojů je opravdu celá řada a stále vznikají nové. Podvodníci často využívají také automatické překlady, jaké známe z Google Translate,“ pokračoval šéf společnosti BigHub.

Podvodníci nepotřebují perfektní video

Čím dál častěji se též objevují útoky cílené na konkrétní osoby a firmy. Zaměstnanci firmy může tak například volat jeho falešný finanční ředitel. Příkladem za všechny z domácího prostředí je útok na vedení slovenského e-shopu Gymbeam, kdy se podvodníci vydávali na za zakladatele firmy Dalibora Cicmana. Přes WhatsApp pozvali konkrétního zaměstnance firmy na videohovor, kde byl právě deepfake zakladatele a další osoba představená falešným Cicmanem jako právník firmy. Cílem útoku bylo získat informace o firemních účtech.

Tomáš Hubínek

Spoluzakladatel a ředitel v technologické společnosti BigHub, která pomáhá českým i globálním firmám využívat umělou inteligenci. Vystudoval softwarové inženýrství na FJFI ČVUT v Praze a nyní zde vyučuje předmět zaměřený na zpracování dat a AI. Pracovní zkušenosti sbíral mimo jiné ve švýcarském CERNu. Mezi klienty BigHubu patří například Pražská plynárenská, GoodData nebo ČEZ.

Když se ovšem vrátíme k nejčastějším falešným videím na sociálních sítích, ty mají k perfektnímu stavu stále ještě daleko. Problémem ale je, že to v těchto případech bohatě stačí. „Útočníci se nesnaží vytvořit jedno dokonalé video, ale spoustu ucházejících. Běžného člověka přitom mohou i tato videa svou kvalitou oklamat naprosto jednoduše,“ varuje expert na umělou inteligenci.

„Musíme si uvědomit také kontext – video se objeví uživateli nejčastěji během brouzdání na sociálních sítích na telefonu, nemá tak plnou pozornost a videa sleduje v nízké obrazové kvalitě, kde nerozezná detaily,“ poznamenal na závěr Hubínek z BigHubu.

Bohužel, celý boj s falešnými videi má ještě jednu vrstvu – sociální sítě je často neodstraňují ani po opakovaném nahlášení. Ze zkušeností redakce CNN Prima NEWS skončilo upozornění na falešné reportáže konstatováním ze strany technické podpory, že „nezaznamenala žádný problém, který by porušoval pravidla užívání služeb společnosti Meta“.

MOHLO VÁM UNIKNOUT: Evropská unie schválila pravidla pro umělou inteligenci. Některé systémy chce zakázat, jiné regulovat.

Doporučené články

Viet Tran pracoval pět let jako redaktor na webu Echo24.cz. Několik let řídil magazínové sekce herních projektů SkillZone.cz a Battleforce.cz, poté spoluzaložil občasník Cooldown.cz. Média vystudoval na Univerzitě Karlově, diplomovou práci zpracovával v Japonsku, kterému se profesně věnuje do současnosti.